Hace unas semanas, un investigador de la Bayerischer Rundfunk (Radiodifusión Pública Alemana) se hacía eco de una investigación llevada a cabo por compañeros suyos sobre la supuesta eficacia de la inteligencia artificial a la hora de evaluar a los candidatos en una entrevista de trabajo. La conclusión a la que llegaron era que existía sesgo también por parte de la IA (inteligencia artificial), que no es algo exclusivo del ser humano. El debate sigue estando aún vigente en redes sociales, lo que ha puesto en evidencia las carencias de esta forma de evaluar candidatos.

Hakan resumía el estudio de sus colegas de profesión explicando que habían analizado "entrevistas de trabajo basadas en inteligencia artificial" realizadas por un software que "promete ser capaz de detectar rasgos de personalidad y ser ‘más rápido, pero también más objetivo’". ¿La conclusión? "Con solo colocar una estantería en el fondo, los resultados cambian significativamente". Esta apreciación ha sido recuperada esta semana por el usuario @fasterthanlime, que, a su vez, relanzaba un mensaje suyo en el que ya planteaba dudas sobre este sistema. "¿Qué idiota lo llamó ‘aprendizaje automático’ en lugar de ‘automatización de sesgos’?", publicó entonces.

Visite el sitio de E&N para noticias de Pymes y emprendedores: estrategiaynegocios.net/pyme-emprende

El debate sobre la utilidad, fiabilidad y supuesta imparcialidad de la IA para las entrevistas de trabajo lleva tiempo en cuestión. La investigación realizada recientemente en Alemania tomó como materia de estudio las entrevistas de un software de una start-up con sede en Múnich y gran apoyo financiero. Lo que descubrió es que sí había sesgo y que los resultados, con la misma persona, podían variar dependiendo del fondo o de los accesorios que se pusiese.

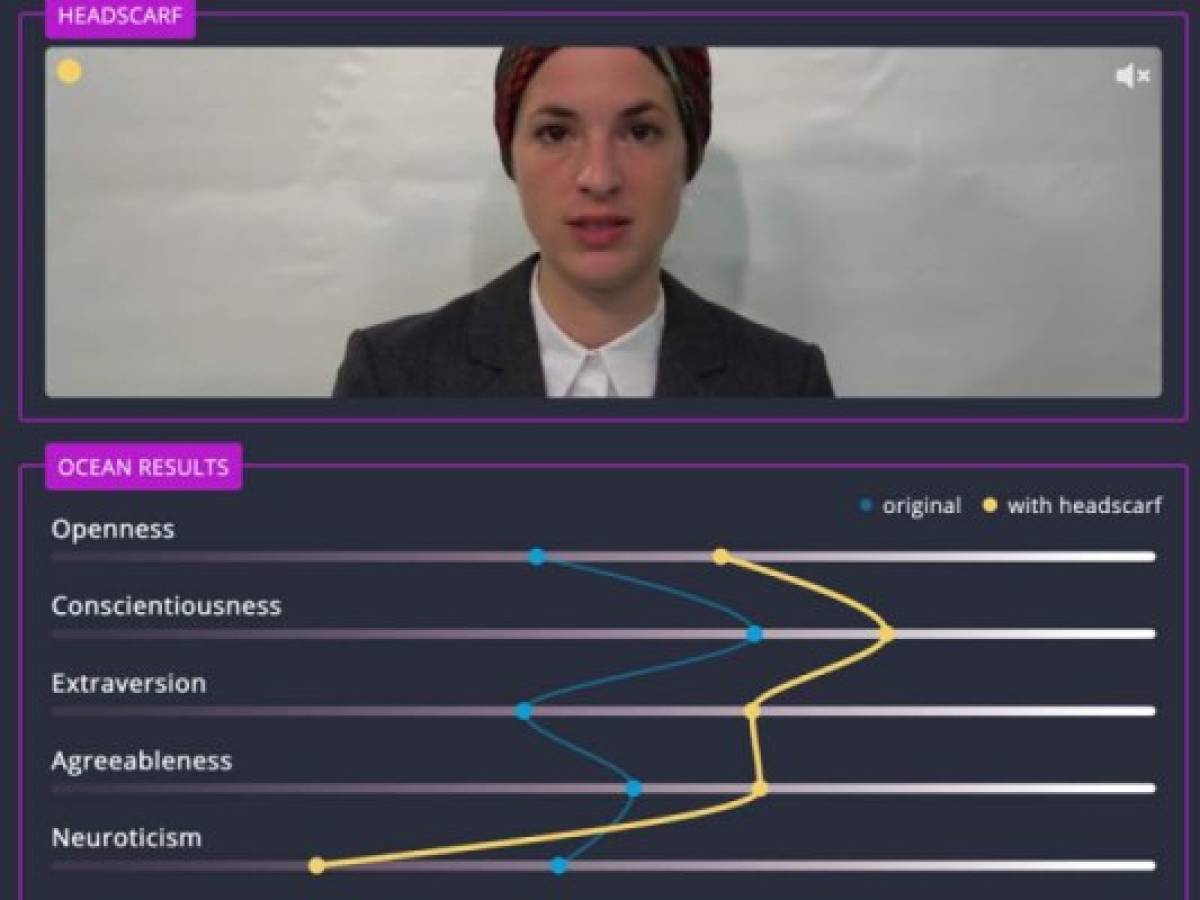

Por ejemplo, este software evaluaba a un candidato con una estantería detrás como más abierto, consciente, amable y extrovertido. La promesa es que lo que se evalúa es el tono de voz, el lenguaje, los gestos y las expresiones faciales. Pero lo que demostró esta investigación es que cosas como el uso de gafas pueden cambiar la apreciación de la IA. La misma chica con gafas era evaluada como menos responsable y más introvertida. Con un pañuelo cubriendo su cabeza se la valoraba como más abierta y amable. Que estas cosas afectasen es algo que no esperaban los investigadores.

La línea azul corresponde a la evaluación de la mujer que aparece en pantalla cuando no lleva pañuelo, y la amarilla cuando sí lo lleva. Sorprendentemente, los valores de franqueza, extraversión, amabilidad y diligencia son superiores, por tanto más positivos. El de neuroticismo, o inestabilidad emocional, es inferior, por lo tanto positivo también. Es solo un ejemplo de varios con los que el estudio pretende enseñar estos prejuicios.

En los resultados de su análisis, que puede consultarse en línea en inglés, señalan que la start-up dice de su sistema que es "más rápido, sino también más objetivo y justo". Algo que no parece demostrar los resultados obtenidos por ellos.

Estas conclusiones se suman a las publicadas por Observer a comienzos de este año, cuando recogían las dudas que este sistema de reclutamiento despierta en un reportaje titulado Su próxima entrevista de trabajo puede ser con un robot, se dé cuenta o no. En él explicaban los usos de la IA en las entrevistas de trabajo y destacaban que su uso "se ha generalizado cada vez más en el reclutamiento en los últimos años".

Como ejemplos señalaba empresas como Hilton y Unilever y aportaba la estimación de que "el 83% de las empresas estadounidenses utilizan alguna forma de inteligencia artificial en sus procesos de recursos humanos". Pero no se trata de la panacea, como ya señala la investigación alemana. En 2018, por ejemplo, Amazon dejó de usar un programa que discriminaba a las mujeres.

Prasanna Tambe, profesora asociada de operaciones, información y decisiones en la Wharton School of Business de la Universidad de Pensilvania, en declaraciones a Observer, dejaba claro que "los algoritmos pueden estar sesgados y discriminar injustamente a algunos grupos en el proceso de contratación".